Lire la suite

Travailler dans un monde de données

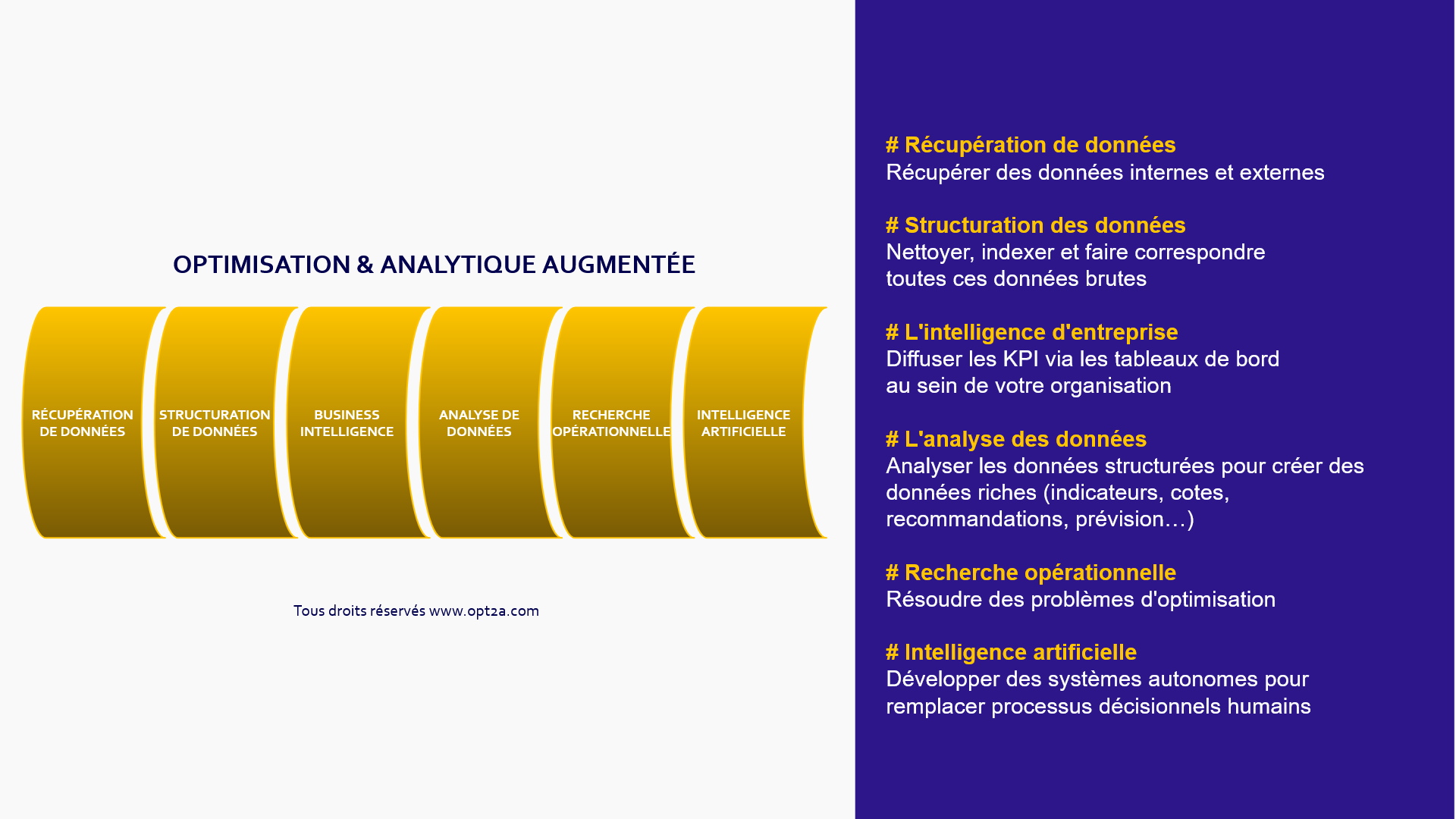

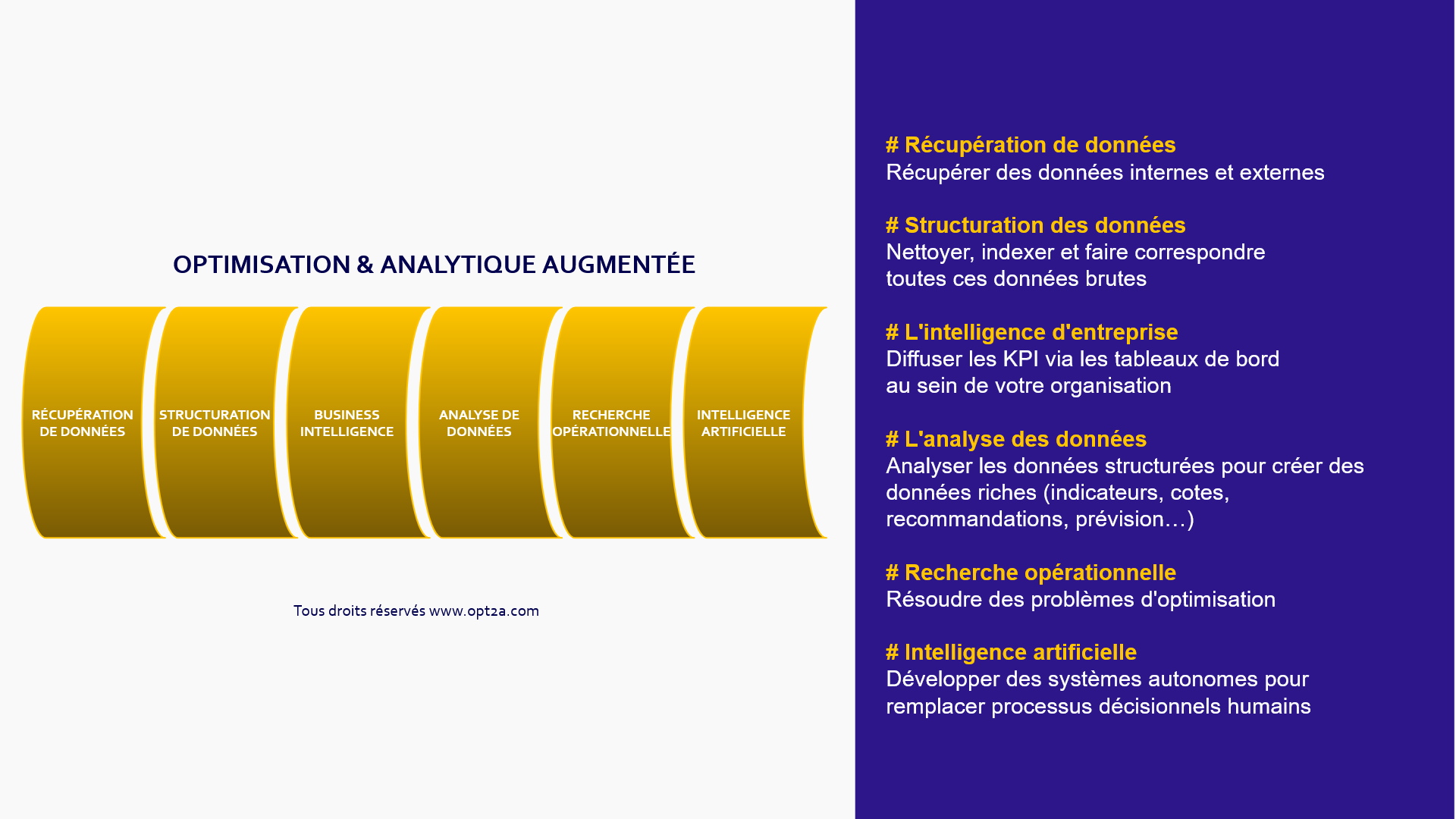

Depuis quelques années déjà, on entend parler abondamment dans les médias, en conférences ou à l'université de l'Intelligence Artificielle appliquée à toutes les disciplines. Le terme englobe souvent beaucoup de domaines, ce qui rend la compréhension de l'ensemble des 'Métiers de la Donnée' assez complexe. Voici une proposition de classification des disciplines, présentée à plusieurs reprises lors de conférences et qui a déjà donné lieu à quelques débats (et des ajustements !). Je vous partage aujourd'hui ce document sous forme d'un article afin de toucher un public plus large, dont les services RH ou les managers qui doivent désormais recruter ces nouveaux profils, ainsi que les étudiants qui doivent faire un choix pour leur future carrière parmi l'ensemble de ces disciplines aux caractéristiques souvent bien différentes

Cet article a été publié sur Linkedin en Français le 11 Novembre 2018 - Tous droits réservés

La classification proposée est décomposée en 6 métiers de la DATA SCIENCE. C'est une vision subjective et perfectible. Pour tout contact : contact@opt2a.com

# 1 - LA RÉCUPÉRATION DES DONNÉES

La première discipline regroupe les métiers autour de la récupération des données (ou Data Scraping). En fonction des sociétés, cette récupération peut consister en l'installation de trackers physiques (capteurs/caméras/drones/...) ou numériques (balises web de tracking, opt-in, ...). La récupération de la donnée peut également passer par du crawling, c'est à dire des outils informatiques consistant à capter des données publiques disponibles soient en open data, soit sur des sites publics (technique utilisée notamment par les moteurs de recherche pour l'indexation des contenus publics). Dans les entreprises ou les administrations, la récupération des données peut également signifier la consolidation de données éparpillées au sein des directions ou non numérisées, afin de l'inscrire dans des bases de données centralisées. Cette consolidation nécessite souvent la mise en place de standards d'échanges.

Profils : Ingénieur informatique / Développeur

Mots Clés : trackers, crawling, consolidation, parsing.

# 2 - LA STRUCTURATION DES DONNÉES

Une fois ces données récupérées, il va falloir les ranger. On parle de structuration des données ou de data management. Pour cela, on utilise des techniques d'indexation afin de passer de données brutes à des données structurées. Ces processus étant souvent à réaliser de manière régulière (toutes les minutes, heures, jours, semaines, mois... en fonction des activités), on utilise pour cela des ETL, c'est à dire des algorithmes (ou des logiciels) qui vont permettre d'effectuer des synchronisations massives d'informations d'une source de données vers une autre en procédant à des labellisations. A l'image d'une bibliothèque qui recevrait un semi-remorque de livres devant sa porte à intervalle régulier, un processus de classement va être nécessaire avant de poser ces livres dans les étagères mise à disposition du public qui retrouvera facilement le contenu attendu, avec une certaine logique. Il arrive parfois qu'on ait besoin d'algorithmes d'apprentissage pour améliorer la structuration des données au sein des entrepôts de données, en réduisant petit à petit l'erreur : on parlera alors de Machine Learning appliqué à la classification. Parfois les volumes de données étant énorme, il faut alors utiliser des applications distribuées et échelonnables en veillant à une structure de base de données adaptées (on parle de Data Lake).

Profils : Data Engineer

Mots Clés : ETL, Indexation, Données Structurées, Data Management, Algorithme d'Apprentissage, Classification, Machine Learning.

# 3 - LA MISE A DISPOSITION DES DONNÉES

Une fois ces données rangées, on va chercher à les diffuser au sein de la structure. A quoi bon disposer de données si c'est pour ne pas les utiliser pour informer ceux qui souhaitent en savoir plus. Pour cela, on utilise généralement des outils de Business Intelligence, qui permettent d'éditer des tableaux de bords (Dashboards) présentant des indicateurs clefs (KPI), des graphiques, des tableaux de données, des rapports de performance. Pour les rendre efficaces, il faut réfléchir à l'organisation des données, à trouver les bons indicateurs qui permettront de ne pas se noyer dans la masse d'informations, mais également penser aux notions de sécurité, de gestion des droits d'accès par utilisateurs et de qualité de la donnée en lançant des scripts de vérification pour ne pas diffuser des Fake Data (dont les conséquences peuvent être plus ou moins graves en fonction des activités). Les données étant souvent désormais la matière première de la décision managériale, la confiance dans les données diffusées qu'arrive à créer le Chief Data Officier avec le reste de la société est primordiale.

Profils : Data Engineer, Administrateur de Base de Données

Mots Clés : Business Intelligence, Dashboard, KPI, Sécurisation, Haute Performance.

# 4 - L'ANALYSE DES DONNÉES

En parallèle de sa diffusion au sein de tableaux de bords, les données structurées peuvent avoir besoin d'être analysées, afin de créer de nouvelles données : on parlera de Rich Data, comme par exemple des prévisions, des indices, des cotes... Ces études vont consister en une analyse des données structurées historisées en utilisant des méthodes et des outils de statistiques avancées. A partir d'une partir des données passées (ensemble d'apprentissage), on va créer des algorithmes / des lois / des probabilités qu'on va vérifier sur une autre partie des données passées (ensemble de test). Ceci afin d'affiner le modèle. Si le modèle est adaptatif et continue d'évoluer par lui-même en devenant de plus en plus précis au fil de la réception de nouvelles données, on parlera de Machine Learning. L'analyse de données nécessite parfois de s'appuyer sur des outils de calculs distribués quand les volumes de données sont trop importants. En effet, un simple processeur ne suffisant pas pour appréhender des paquets de données trop important. On peut aussi décomposer l'apprentissage afin d'améliorer les performances.

Profils : Data Scientists, Data Analysts, Statisticiens

Mots Clés : Analyse de données, prévisions, statistiques, corrélations, Machine Learning, R, Python.

# 5 - LA RECHERCHE OPÉRATIONNELLE

La Recherche Opérationnelle est une discipline qui s'appuie sur des méthodes mathématiques et qui permet d'aider à prendre de meilleurs décisions grâce à la modélisation puis la résolution d'un problème d'optimisation qui tend à maximiser un objectif tout en respectant un ensemble de contraintes. Bien souvent, elle prend forme dans les entreprises sous la forme d'outils d'aide à la décision. Contrairement à l'Intelligence Artificielle, les logiciels de Recherche Opérationnelle ne prennent pas la décision à la place des humains mais ils permettent à l'opérationnel d'avoir accès à toutes les données (brutes ou enrichies) pour prendre sa décision. On retrouve parmi les thématiques principales : la planification (de personnel, de ressources, de projet, de publicités, de services,...), le pricing (yield, adaptatif, tarification complexe,...), la simulation (méthodes d'apprentissage, méthodes statistiques, ...) et de manière plus générale l'algorithmie (calcul distribué, haute performance, heuristiques...). C'est pourquoi la Recherche Opérationnelle intervient généralement quand les phases 1 > 4 ont été correctement mise en oeuvre dans la structure : difficile de mettre en place un logiciel d'aide à la décision si les données (géographiques/stocks/ventes/personnels...) ne sont pas disponibles et structurées. De plus, ces outils vont s'appuyer en entrée sur des prévisions futures afin de prendre une décision à l'instant t qui maximisera le critère d'optimisation choisi.

Profils : Ingénieur Recherche Opérationnelle (Plus d'infos : www.roadef.org), Revenue Manager, Ingénieur Informatique.

Mots Clés : Planification, Optimisation, Aide à la Décision, Simulation, Algorithme, Yield, Revenue Management, Pricing.

# 6 - L'INTELLIGENCE ARTIFICIELLE

L'Intelligence Artificielle, au sens originelle du terme, concerne les disciplines qui consister à aller plus loin que l'Aide à la Décision, avec une prise de décision par la machine sans intervention humaine. Les méthodes utilisées sont notamment des moteurs de règles ou des algorithmes plus complexes pouvant faire appel à des automates s'appuyant sur des réseaux de neurones (classifieurs), sur la résolution générale de problèmes et la logique des prédicats. Tous ces algorithmes s'appuient dans tous les cas au préalable sur des études de données (machine learning, deep learning, ...) et une configuration humaine.

Pour le moment, les principales applications connues sont dans le domaine de la Finance et les Banques (trading automatisé), en Logistique (robotique et traitement de tâches automatisé), en Transport (conduite automatisé), en Jeux Vidéos (intelligence adverse) et en Service Clients (Chatbot).

Pour les domaines Militaires, en Médecine ou encore en Droit, on est pour le moment plutôt dans de la Simulation, de l'Analyse ou de l'Aide à la Décision avec des outils qui viennent (pour le moment) seconder l'humain plutôt que le remplacer. On voit également des initiatives arriver dans le domaine de l'Art (création d'oeuvre par application d'un style) ou de la Programmation informatique (codage automatique d'applications simples).

Profils : Artificial Intelligence Engineer (Plus d'infos : www.afia.org), Robotics, Computer Engineer.

Mots Clés : Robotique, Réseaux de Neurones, Automatique, Chatbot.

GOUVERNANCE

Et pour compléter la présentation de ces disciplines et des profils qui interviennent au différent maillon de la chaîne, les profils qui vont venir 'orchestrer' l'ensemble de ces activités sont selon les entreprises directement le Directeur Technique (CTO) ou le Directeur de la Donnée (CDO). Les sujets Aide à la Décision sont également parfois gérés par le Directeur du Revenue Management, le Directeur Production, le Directeur Logistique ou le Directeur Commercial. Les sujets Intelligence Artificielle, souvent assez récents, reviennent au Directeur de la R&D ou au Directeur Technique selon les structures.

N'hésitez pas à commenter par email à contact@opt2a.com à propos de votre organisation.

Antoine Jeanjean, contact@opt2a.com

OPT2A BLOG

OPT2A BLOG

Comment le Pricing peut se mettre au service d'une économie plus durable et responsable ?

OPT2A BLOG

Travailler dans un monde de données

Depuis quelques années déjà, on entend parler abondamment dans les médias, en conférences ou à l'université de l'Intelligence Artificielle appliquée à toutes les disciplines. Le terme englobe souvent beaucoup de domaines, ce qui rend la compréhension de l'ensemble des 'Métiers de la Donnée' assez complexe. Voici une proposition de classification des disciplines, présentée à plusieurs reprises lors de conférences et qui a déjà donné lieu à quelques débats (et à des ajustements !).

Lire la suite

OPT2A BLOG

La valorisation des données en cette période de surchauffe sur les sujets DATA / I.A.

Pour reprendre l'expression utilisée par nos amis Niortais de Kereon Intelligence venus récemment faire une (très bonne) présentation à Bordeaux sur la Data Literacy : 'la data peut être désormais comparée à de l'or' ! Les données ont pris une telle importance pour les sociétés, les organisations, les administrations et les états que les données sont le véritable or noir du XXIe siècle. Et comme toute ruée vers l'or, on assiste à une véritable « montée en pression » sur ces sujets en lien avec la Data ou l'IA

Lire la suite

OPT2A BLOG

Automated Pricing : la tarification dynamique automatisée

Les dernières années ont vu se développer au sein des sociétés du e-commerce une multitude d'outils d'aide à la décision permettant de pratiquer de la tarification dynamique (ou Dynamic Pricing). Ces outils de Recherche Opérationnelle intègrent le niveau du stock, l'écoulement, le niveau de marge cible, le taux de transformation, les prix des concurrents...

Lire la suite

Contactez-nous

Antoine Jeanjean (PhD)

Contactez-nous en utilisant directement ce formulaire,

nous vous répondrons dans les plus brefs délais